你对2024年学习数据有好奇心吗? 但对机器学习中如何处理道德考量有好奇心吗?深入了解关键领域后, 我们坐下来与一位专家商谈, 以深入了解业界

一位经验丰富的工程师William Tracy帮助设计职业Foundry新手机器学习ython课程,特别是机器学习课程伦理方向部分找谁谈数据中的AI道德问题比较好

William北卡罗来纳本地人机械工程高手BS和玩具设计BA设计操作重机械大玩具 并是连接设计优化专家专业工程师, 并分解制作3D打印 和机器学习

我破解访问题目, 你可以用可点击菜单商谈它:

访问数据专家William Tracy

Hi威廉可告诉我们你的历史 处理资料和道德

威廉特蕾西:自2005年起我一直当机械工程师 并当PE自2009年起(专业工程师)

职业工程师意味着你守职业道德标准, 违反职业道德, 有可能失去工作特权

工地卡特比勒公司小型建筑设备性能工程师分析师卡特比勒拥有一套非常成熟的道德规则,因为公司已超过100年

要求所有员工完成年度行为规范并自报当年的任何违反道德行为,包括供应商馈赠可被视为贿赂、与其他公司串通和哪些数据可自由用于设计中公司非常小心避免甚至感知使用非它拥有的数据

原位IBM系统85%的消费者表示组织使用AI时必须考虑到道德问题, 公司如何尽可能快速和有效地教育自己道德问题?

威廉特蕾西:最重要的是记住传教AI 是它背后没有情报数学公式更名机器学习.

道德规则集成 人性道德规则 其中一些范围为主观性个人、公司或国家可能违反道德的行为可能非他人行为。

使用AI时,生成的答案从许多其他例子中生成,有时用受控数据集生成,有时上网自由收集那你怎么知道你使用谁的道德

AI常被卖成黑盒 以显性魔术解决你的问题最重要的是公司理解AI使用的数据源头, if not excernated规范数据

归根结底,没有人智能生成回答必须由人检验以确定它是否遵循该组织使用的一套道德规范

数据道德考量

描述你在工作中遇到伦理难题的时段

威廉特蕾西:公司在Caterplyl工作时要求雇员避免甚至是感知折曲他们的一套道德一天后,我应邀与一名代表会晤大型建设大会相遇时,我得到了一包swag类免费表单靠它本身不构成道德问题

然而,当离开大会时,我终于查看包并发现包中还装有非常好的领带插针万一我还没有离开大会,我本会还送礼物的 公司可以视之为行贿视本国通用道德守则而定,另一公司可能不考虑这一点。

幸运的是,我们最终不考虑公司最终排队供货商,这就消除了我考虑他们的馈赠是否影响我意见的需要

道德考量如何影响职业FoundryML专业课程设计

威廉特蕾西:道德是写职业FoundryML规范课时主要影响之一机器学习是一个进化学科, 特别是在过去4-5年中, 进入新增长和推送边界正因如此重要的是学习它, 因为它正在影响越来越多的系统

这个临Τ表示没有完全实现的道德守则使用机器学习和基因化AI时参考有时很难知道 何时新发明 有可能对它所影响者 产生真正的问题学生实验机器学习等新技术时, 关键是思考技术如何以意外方式影响他人

可分享课程中解决道德问题的具体例子或模块吗?

威廉特蕾西:任务1.2课程具体处理机器学习的道德问题,处理已经在这里介绍的许多题目深思熟虑地放入课程前 大部分技术都向学生解释 因为这也是设计过程中

开机前先想一想新技术在哪里和如何使用,如果有直接可见的不良效果,在启动机器学习项目时可设计或消除

其中一些问题,例如不经许可使用版权图像或文本问题,如果技术创建者更仔细地考虑伦理问题并加诸保障措施以防误用,本可完全避免。

以你的观点看,为什么数据专业人士有必要以道德为根基?

威廉特蕾西:能力考虑开发问题或技术的长期效果不同于技术知识创造或理解技术技术知识或信息处理需要不同原则的创建性,一种道德原则的创建性,另一种技术知识或信息处理性原则的创建性人越看艺术 人越科普科普科普科普科普科普科普科普科普科普科普科普科普科普科普科普科普科普科普科普科普科普科普科普科普科普科普科普科普科特科普科普科普科普科普科普科普科普科普科

正因如此, 许多人若专注于特定学科,数据专业人士也从道德考量入手,可能能够更好地考虑信息的长期效果,即处理信息用它和用它放入信息的长期效果

培训模型使用合成数据在道德方面有什么意义?

威廉特蕾西:使用道德流传现实世界数据的一个解决办法就是使用合成数据集取而代之

再一次最好先考虑数据出自何方.合成数据表示删除道德问题,因为数据生成而非实仍有必要思考数据是如何生成的, 以及数据创建时是否有固有偏差增加

运行数据时 有可能增加模型误差 最终产品, 因为合成数据不捕捉现实世界所有方面和用法最后,如果合成数据不捕捉现实世界问题,这可能允许当模型最终接触真实数据时出现意外道德问题。

规程策略

管理环境为机器学习和AI演化

威廉特蕾西:慢速度,尽管它正在加速 更多人意识到危险问题重现于此 新技术是如何固化的 规则制定前

人工智能方面也有许多误解, 正因如此我偏爱使用“机器学习 ” 。 许多新政府委员会首先集中研究人工智能战争使用方式大问题拥有机器学习模型 管理军事力量 而不强人监督 问题我们迄今所见

然而AI已经人和公司认为可以获取产品 通常由人提供 廉价或免费机器学习模型.艺术家和作者对AI生成的艺术和文本大呼小叫中看到这一点, 公司也看到这一点,公司决定放人制作公司假设会由AI创造出“足够好”。

监管委员会正在由美国政府设置 研究现在, 但政府规则也移动极值慢点

各委员会将研究已经举个例子说明应该是完成能看到哪里引出问题吗

机器学习程序达标后会有什么后果

威廉特蕾西:先看艺术界人民少钱少能力改变策略公司会起诉并保护自己不受律师伤害单画家准备做什么? 图片重新编译由AI销售? 或写作者写出三本新书

一开始创建机器学习程序的人当然应该受部分责备,民心使用它重造产品为他人收入者使用者是否有罪,因为产品免费提供,没有规则说明他们的行为不道德或违法?道德应作为设计初级技术,思考新技术可使用的方式和地点以及它可影响谁

用户隐私

机器学习模型如何对用户隐私构成风险

威廉特蕾西:机器学习模型建基于大量原已存在数据数据可以是真实数据或生成数据

使用真数据时 有可能精确数据 深入模型输出记住选择穿透模型层后没有情报都基于数学, 所以没有什么可以阻止私密信息传递, 除非人把权宜之计放入模型中

真实生化例子 并发现生成图像模型从互联网上抓取艺术 即艺人签名持续显示 机器学习生成图片 即便原创作者明白声明 他们的作品不为这些系统使用

培训模型时确保数据隐私的最佳做法是什么?

威廉特蕾西:避免数据隐私问题的最佳方式是训练模型时不使用私有数据.之后它不可能穿透模型层并排出另一端

人工或合成数据可用以填充培训数据集,这样用户隐私就不会有风险然而,当这不切实际时,裁剪和控制原创数据集可能也行得通。这需要数据科学家做更多工作创建模型(先传递道德后果)以确定什么可接受和哪些不可接受用于培训集

模型部署后,从持续监控和更新入手的道德考量是什么?

威廉特蕾西:工程设计中众所周知, 原创概念删除问题只花点时间, 初始设计删除问题可能花点小钱或时间重新设计, 陷入原型设计问题可能在重构模件或变换供应商方面花费点或大或小设计修改最大成本来自对客户已有产品需要回调或更新时。

类似地 模型部署后 被那些与原创创建者或团队无关的人使用很容易监控自己的道德行为几乎不可能规范他人的道德行为,除非受规范法约束

发布机学习模型要么有道德故障,或用户发现特征可用于不道德行为,创建者应该是道德补丁或修改模型,以便无法重用破解这可能要求删除访问模型或对模型进行新数据集再培训并丢失所有培训经验也可能是不可能的,如果其他人自己复制或重造模型

问责制和责任制

机器学习模型出错或造成损害时,谁应负责?

威廉特蕾西:关于许多新技术,这是一个相当复杂的问题:

- 模型创建者对模型使用方式有误吗?

- 用户寻找新方法使用模式是否因无规范而超出道德标准?

- 是否政府或管理机构不创建模型使用指南的错

微小点所有这些, 但由于机器学习非常新, 至少在使用时 大批人使用, 尚没有先例已经有官司逼近第一代机器学习和AI模型中的错误和错误,这些都有可能创建框架来确定未来由谁负责

组织如何确保负责任的ML模型开发部署

威廉特蕾西:let you 跳过一天历史并改变历史, 你会按下按钮并编造它吗?希望你能稍微思考一下 后果是什么 和出错

类似地 AI如何影响组织输出和利润没有先例很容易接受你所认为的 富人快速计划, 但一旦结果到来, 他们可能令人失望。研究部分内容创建博客,AI助手机器人并媒体公司最近上新闻举例子实践前思维和部署前评估风险将在未来使用AI实战时省下公司巨资

是否有任何工具或框架供你推荐评估机器学习中的道德考量,超出偏差检测

威廉特蕾西:有几个道德框架设计引导你 通向最优判断 道德判断第一,我建议退房

和那些,有两种简单方法 思维通过这一点:

- 需要别人来这样对我吗

- 我有任何私利(金钱、权力、影响力、家庭、羞耻.)影响我的判断?

说到此,伦理学总是基于社会 和你熟悉的价值观时间变化和地理变化 在某种程度上注意信任,只对一组复选框来确定你是否做对事, 特别是如果那事以前从未做过!

选择动作前, 并使用工具后, 退步并看项目整体观察谁和它会影响什么应用内部对错感并问道:

大世界

数据专业人员在确保ML技术惠及全社会方面起什么作用

威廉特蕾西:数据专业人员在机器学习方面处于独特位置他们知道技术的内涵和外涵 多数人对此视而不见

多AI机器学习工具黑盒售出 终端用户不需要知道 香肠制作方式数据专业人士知道“香肠制作方式”,至少部分是这样的, 即使他们没有完全评价决策的道德训练, 也可以向做人解释函数和结果

ML实践者与伦理学家或来自其他学科的专家协作有多重要

威廉特蕾西:直接导出上文问题机器学习从业者没有道德背景 与专家协作是学习道德和确保正确决策的好方法

除偏差外,你预测未来十年机器学习和AI会遇到什么新伦理挑战?

威廉特蕾西:有很多简表问题有:版权与IP,plagiorism,出国“洗钱”,市场超载某些创物和创品质量

以上都是机器学习模型和AI助手实例,其中许多正在发生中。还有一个大问题 深入机器学习与人工智能差别的核心

记住内部没有智能驱动机器学习模型结果-这只是数学情报部分归用户所有然而,随着模型更加复杂化, 有可能创建出更精密系统 使用机器学习, 和那些巢机学习模型我们必须总检查这些系统 真实智能规模

尚无法制造出像人一样能 作出知情决策自我向导的机器即实人工智能如果发生这种情况(而我个人认为如果发生,则仍差50-100年),那么我们就有一套完全不同的伦理问题,必须加以考虑。如果我们使用自觉系统执行任务,我们现在必须问它是否值得被像人一样对待,以及我们是否值得我们对待罐头任务使用它

设计职业FoundryML专业课程

可分享现实世界实例 机器学习中的道德考量 严重影响项目结果

威廉特蕾西:A级2023年8月法院裁决表示I-Creted艺术无法在美国接受版权立即对计划为商业目的颁发AI艺术许可的任何公司产生影响

举个例子 任何人都可以使用艺术 因为它不可限制不久的将来肯定会质疑这项裁决,并可能逆转也可以应用到AI创建的其他内容不确定性直接影响到公司使用由帮助或完全由AI创建的内容的想法

职业FoundryML专业课程如何训练学生应对职业道德挑战

威廉特蕾西:机器学习专业课程专为鼓励学生思考项目道德问题而设计

全部教程都用在道德上 伦理问题必须在最后项目中考虑完成项目时以这种方式思考会帮助学生准备在工作上考虑道德挑战

持续学习和更新ML职业知识有多重要

威廉特蕾西:vwin德赢娱乐官网数据解析和机器学习较新学科, 执业者更有责任确保持续学习现场知识并跟上最新动态特别因为字段变化如此之大 了解最新进展可能意味着 检测求职面试

感谢威廉时间

总结阅读

嗯,我希望你从启发式面试中得到了很多 关于机器学习中道德考量 与非常熟悉现场的人学习提醒自己,这里有密钥外送

- 道德是一套人的道德规则,其中一些范围是主观性规则。个人、公司或国家可能违反道德的行为可能非他人行为。

- 使用AI时,生成的答案从许多其他例子中生成,有时用受控数据集生成,有时上网自由收集那你怎么知道你使用谁的道德

- 数据专业人员必须打入道德基础,因为研究开发问题或技术的长期效果的能力不同于技术知识创造或理解技术

- 规则与策略促进机器学习 AI演化缓慢 AI有很多误解

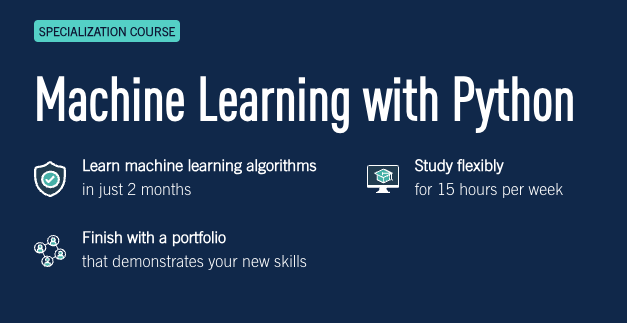

威廉等经验丰富的行业专家 引导和帮助 研究机器学习 听上去有吸引力Python专业课程机器学习都是为了你远程完全导师课程中,你学习如何建立并部署机器学习算法2个月, ML项目展示它

如果您想多读机器学习先查这些文章